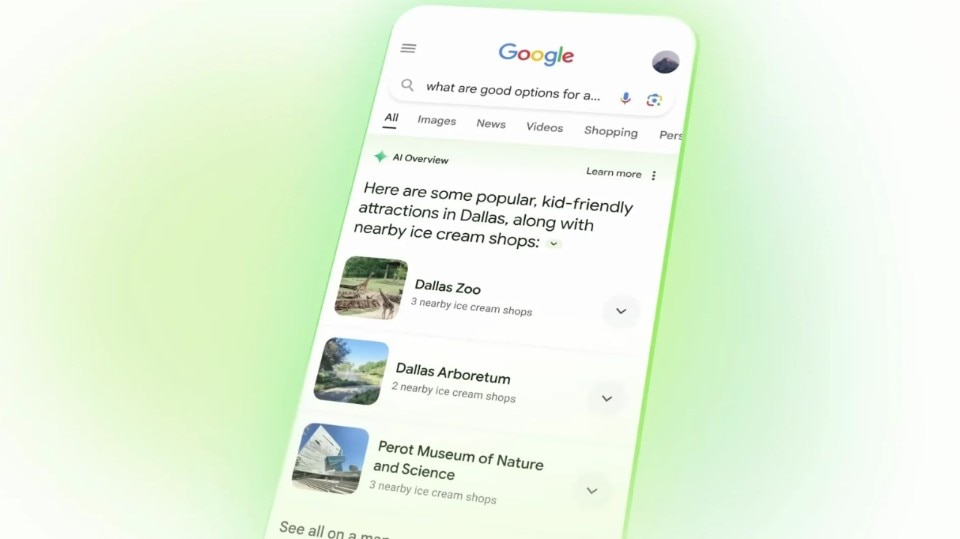

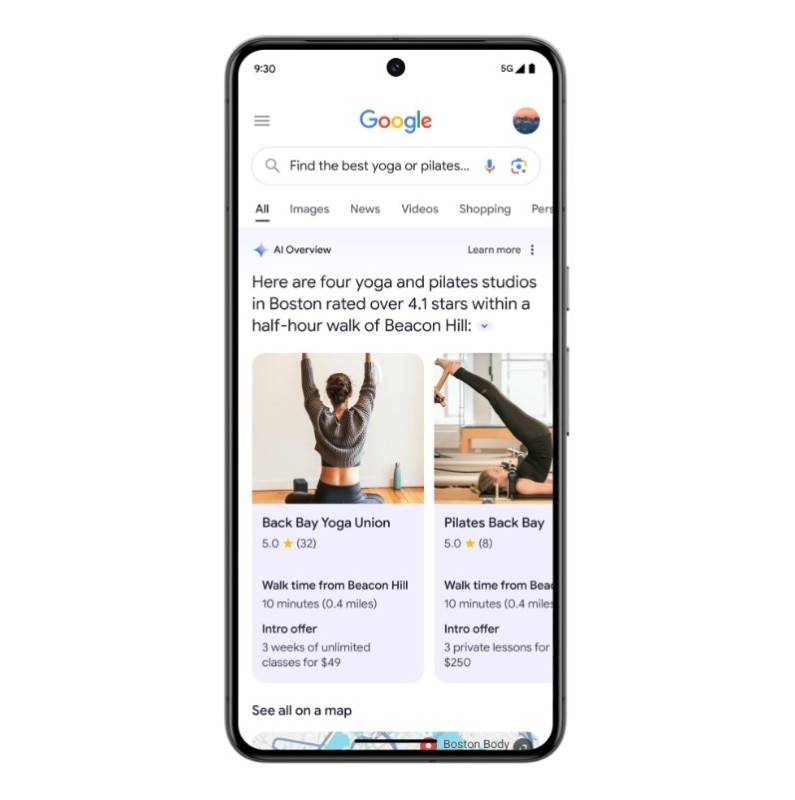

“Google googlerà per voi”. Il lancio di AI Overviews – la nuova funzionalità del motore di ricerca basata su intelligenza artificiale – è avvenuto durante la conferenza I/O dello scorso maggio ed è stato accompagnato da questa promessa (in inglese, “Google will do the googling for you”): niente più faticose ricerche compiute districandoci tra contenuti di pessima qualità, rintracciando il paragrafo che ci serve tra testi chilometrici o smarrendoci nei labirintici thread di Reddit.

Grazie all’integrazione del large language model (Llm) di Google – chiamato Gemini e che genera contenuti di ogni tipo rispondendo a nostre richieste formulate in linguaggio naturale – sarà sufficiente porre una domanda per ricevere un testo che riassume le informazioni per noi, liberandoci per l’appunto dall’incombenza di dover cercare, filtrare, trovare ciò che ci serve.

Questa, almeno, era la promessa. Come previsto da più o meno tutti gli addetti ai lavori, le cose non sono andate secondo le speranze del colosso di Mountain View. Nel giro di pochi giorni, hanno infatti iniziato a moltiplicarsi le testimonianze degli incredibili errori commessi da AI Overviews che, per fare solo pochi esempi, ha consigliato a un utente di aggiungere della colla alla pizza, a un altro di mangiare almeno un sasso al giorno e poi ha fornito informazioni relative alla religione musulmana di Barack Obama (che è invece cristiano protestante) e altre assurdità.

Come funziona Overviews

Per capire perché il sistema che dovrebbe “googlare” per noi invece attenti alla nostra salute e confermi le teorie dell’ultradestra statunitense bisogna prima fare un passo indietro. Come funziona un sistema come AI Overviews? Alla sua base, un large language model è un algoritmo di intelligenza artificiale addestrato attraverso un dataset che contiene una quantità immensa di testi (per esempio, l’intera Wikipedia in lingua inglese, gli articoli delle più note testate del mondo, tutti i contenuti presenti su Reddit e altro ancora).

Analizzando questa mole di testi, il large language model impara a generare testi, prevedendo quale parola abbia la maggior probabilità di essere coerente con quella che l’ha preceduta (per esempio, che la frase “porto il cane” debba essere probabilmente seguita da “a fare” e poi “una passeggiata”). In tutto ciò, però, l’intelligenza artificiale non ha nessuna idea di cosa sia un cane, una passeggiata o di cosa significhi il verbo “fare”. Si limita invece a eseguire un calcolo statistico basato su una quantità immensa di informazioni.

Nella maggior parte dei casi, tutto procede per il verso giusto e il large language model è in grado di fornirci un’informazione corretta. In molti altri casi, però, questi sistemi possono presentare come se fossero dei fatti delle informazioni sbagliate o completamente inventate. Il politico australiano Brian Hood, noto per le sue battaglie anti-corruzione, è stato per esempio descritto da ChatGPT come se fosse un “politico corrotto arrestato per corruzione” (informazione eliminata dopo la minaccia di querela di Hood). Galactica di Meta aveva invece descritto come se fosse un fatto storico una notizia completamente inventata relativa ad alcuni orsi spediti nello spazio. E poi ci sono le assurdità, circolate sui social, in cui questi modelli spiegano che Hillary Clinton è stata presidente degli Stati Uniti, che un chilo di ferro pesa più di un chilo di piume e un sacco di altri ridicoli strafalcioni (noti con il termine tecnico “allucinazioni”).

Come siamo arrivati alla colla sulla pizza, quindi?

Attenzione, però: AI Overviews funziona in maniera diversa da un normale large language model. Per la precisione, il sistema di Google combina le abilità di un Llm e quelle di un motore di ricerca tradizionale. In poche parole, nel momento in cui noi poniamo a AI Overviews una richiesta, il sistema effettua la ricerca tramite Google, individua le fonti che ritiene più affidabili e poi rimastica il contenuto per produrre il contenuto che stiamo cercando.

Nel giro di pochi giorni, hanno infatti iniziato a moltiplicarsi le testimonianze degli incredibili errori commessi da AI Overviews che, per fare solo pochi esempi, ha consigliato a un utente di aggiungere della colla alla pizza, a un altro di mangiare almeno un sasso al giorno.

È quindi un processo in due passaggi – ricerca online sulla base del ranking di Google e rielaborazione delle fonti individuate – che dovrebbe rendere il sistema più grounded (come dicono gli addetti ai lavori): più concreto, solido e basato su informazioni di qualità e costantemente aggiornate.

E allora come si spiegano le allucinazioni relative alla colla sulla pizza e alle diete a base di sassi? Il problema, come tutti sappiamo, è che internet è piena di meme, battute, sarcasmo, disinformazione, propaganda e altro ancora. E non sempre questi sistemi, basandosi sul posizionamento dei siti su Google e sulla loro capacità di rimasticare correttamente i contenuti, riescono nell’impresa di trovare le fonti migliori e di interpretarle nel modo giusto.

Per esempio, la notizia della presunta fede musulmana di Obama è stata causata dalla tesi accademica individuata da AI Overviews, che smontava questa e altre teorie del complotto (ed era quindi materiale accurato), ma aveva un titolo ambiguo: “Barack Obama è il primo presidente musulmano?”. Come scrive la Mit Technology Review, “non solo il sistema ha completamente frainteso il senso della tesi, ma l’ha interpretata nel senso opposto”.

Lo stesso è avvenuto con la colla e con i sassi: informazioni reperite in thread ironici su Reddit. In questo caso, il problema non è dato solo dall’incapacità dell’intelligenza artificiale di distinguere una battuta da un’affermazione seria, ma anche dal fatto che Reddit ha enorme rilevanza per il motore di ricerca di Google (che infatti lo posiziona molto spesso tra le primissime posizioni). “Solo perché qualcosa è rilevante, non significa che sia anche giusto”, ha sintetizzato il docente specializzato in ricerche online Chirag Shah.

Internet è troppo complicato da capire per le AI?

C’è poi la questione delle informazioni tra loro in contraddizione. Poniamo di cercare informazioni tecniche presenti su un manuale che ha avuto più edizioni nel corso degli anni: in questo caso un sistema di intelligenza artificiale potrebbe non essere in grado di individuare le informazioni più aggiornate e attendibili. In altri casi potrebbe invece fornirci un’opinione univoca dove una nostra ricerca ci presenterebbe una varietà di pareri differenti, ecc. ecc.

Questi sistemi sono insomma molto più bravi a sembrare affidabili di quanto invece non siano. Peggio ancora: più è specifico l’argomento su cui stiamo cercando informazioni, più è difficile rendersi conto se il sistema sta commettendo o meno un errore.

Ovviamente, è possibile migliorare Overviews e Google sta effettuando numerosi aggiornamenti tecnici per rendere sempre meno probabile che il sistema cada vittima di allucinazioni, sfruttando a questo scopo i feedback forniti da esseri umani (incaricati di eseguire una moltitudine di ricerche e poi valutare la risposta ottenuta) o segnalando quali ricerche o termini sensibili non dovrebbero generare una risposta.

La verità, però, è che questi sistemi non potranno mai essere accurati al 100%. E che più faremo affidamento su di loro, maggiore sarà il rischio di affidarci a notizie sbagliate, magari su temi di fondamentale importanza come la salute, i risparmi, la politica o altro ancora. Oggi, almeno, sappiamo che mentre eseguiamo una ricerca su Google siamo noi i responsabili del modo in cui valutiamo e utilizziamo le informazioni che reperiamo. Sfruttando un’intelligenza artificiale deleghiamo invece tutto ciò a un sistema che si atteggia a saputello senza invece sapere nulla.

Se le cose stanno così, perché allora i vari Google, Meta e OpenAI si ostinano a proseguire su questa strada? Una possibile spiegazione l’ha individuata il docente della New York University Gary Marcus, che in un post di qualche mese fa ha segnalato come i ritorni economici dell’intelligenza artificiale generativa fossero tutto sommato modesti, e come la speranza di generare ricavi importanti passasse soprattutto dall’integrazione dei modelli linguistici all’interno dei motori di ricerca, dando così ulteriore spinta a un settore che già oggi vale qualcosa come 225 miliardi di dollari.

Il problema dei siti di informazione

I sistemi che puntano a “googlare per noi” presentano però un altro problema. L’ambizione di AI Overviews e dei suoi simili è infatti quella di creare una ricerca cosiddetta “zero click”, in cui non dobbiamo più cliccare su nessun sito internet per trovare le informazioni che cerchiamo. Se questo diventerà effettivamente il futuro, come saranno compensati i siti che oggi producono l’informazione a cui AI Overviews attinge? Nel momento in cui analizza in autonomia – come già può fare – un video presente su YouTube per estrapolare le informazioni che cerchiamo, come farà a monetizzare il creator che quel video ha prodotto?

Fino a oggi, il compito di Google è sempre stato quello di orientarci nel mare della rete. Adesso, sembra avere l’obiettivo di non farci più navigare. Facendo però venire meno gli incentivi economici per la produzione di una larga parte di contenuti, questi motori di ricerca basati su intelligenza artificiale rischiano di far scomparire il materiale a cui essi stessi attingono per generare le loro risposte. ChatGPT, AI Overviews e gli altri non possono creare neanche una briciola di contenuto originale, essendo semplicemente in grado di remixare – in maniera più o meno accurata – ciò che è già presente sul web.

Come ha sintetizzato il New Yorker, “Google e OpenAI sembrano intenzionate a causare l’erosione dello stesso ecosistema da cui i loro sistemi dipendono”. E questo è un enorme problema di cui si sta parlando ancora troppo poco.

Immagine di apertura generata da Gemini, AI di Google